Quando alguém menciona um "PC da NASA", a maioria das pessoas imagina uma máquina de jogos ultrapotente capaz de rodar qualquer título sem esforço. Mas a realidade é bem diferente - e muito mais impressionante. Os verdadeiros sistemas da agência espacial americana são supercomputadores que fazem qualquer PC gamer parecer um brinquedo infantil em termos de capacidade de processamento.

Os verdadeiros supercomputadores da NASA

A NASA opera duas instalações principais de computação de alto desempenho: o NASA Advanced Supercomputing (NAS) Facility no Ames Research Center e o NASA Center for Climate Simulation (NCCS) em Greenbelt, Maryland. Nestes locais, encontramos máquinas que somam milhões de núcleos de processamento e capacidade de armazenamento na casa dos petabytes.

O que mais me impressiona é a escala desses sistemas. O Pleiades, por exemplo, possui mais de 228 mil núcleos de processamento, quase 1 Petabyte de memória RAM e desempenho de 7 petaflops - isso significa cerca de sete quatrilhões de cálculos por segundo. Já o Aitken, usado para testes de voo e modelagem aerodinâmica, chega a 15,6 petaflops de desempenho teórico distribuídos em mais de 370 mil núcleos.

E não são apenas números impressionantes - esses sistemas estão interligados por redes InfiniBand e Ethernet de altíssima velocidade, somando mais de 90 petabytes de armazenamento online e mais de 1 Exabyte de capacidade arquivada. É um ecossistema completo projetado para processar quantidades de dados que seriam simplesmente impossíveis de lidar em qualquer computador doméstico.

Esses supercomputadores são fundamentais para prever trajetórias, simular o clima de Marte e até projetar foguetes mais eficientes. Cada byte processado ajuda a reduzir riscos e aumentar a precisão das missões espaciais

Time do High-End Computing Capability (HECC) da NASA

PC gamer vs realidade da NASA

Enquanto na internet o termo "PC da NASA" virou sinônimo de máquinas gamers caríssimas, a verdade é que estamos comparando coisas completamente diferentes. Um PC gamer de alto desempenho custa entre US$ 3 mil e US$ 5 mil, enquanto os supercomputadores da NASA podem ultrapassar US$ 50 milhões apenas em hardware.

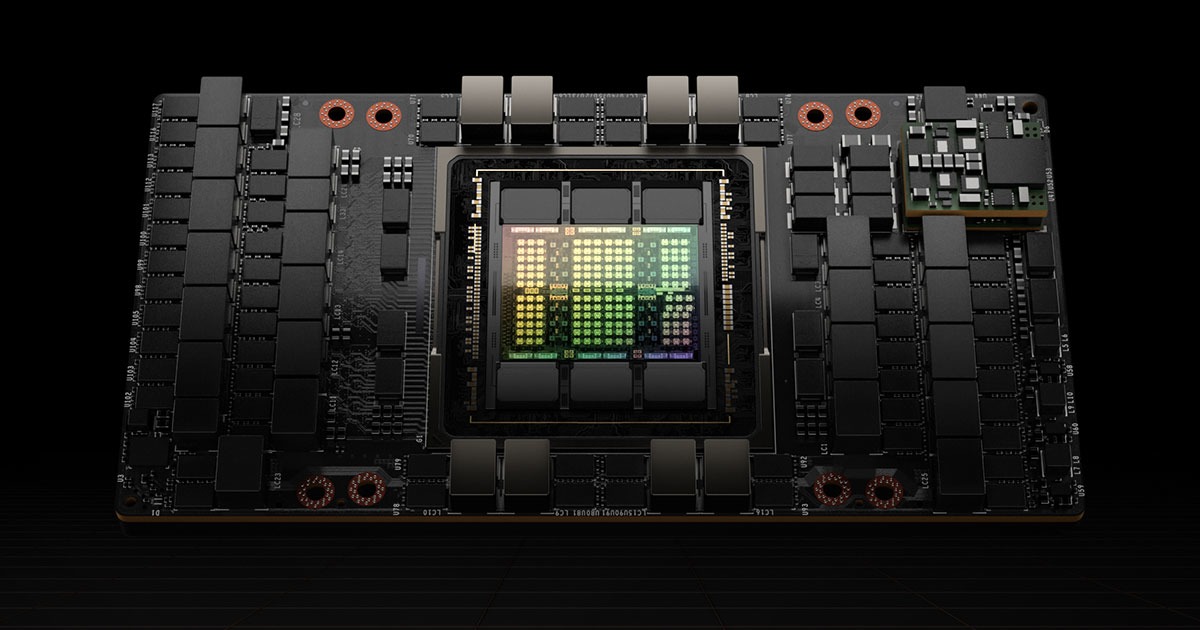

Pense nisso: um PC gamer topo de linha com RTX 4090 alcança cerca de 0,1 petaflop de desempenho teórico. O supercomputador Cabeus da NASA, com suas GPUs A100 e H100, ultrapassa 20 petaflops combinados - isso é 200 vezes mais desempenho! E estamos falando de apenas uma das várias máquinas em operação na agência.

As diferenças vão muito além do poder bruto. Enquanto um PC doméstico roda Windows ou Linux desktop, os sistemas da NASA utilizam Linux científico otimizado. E enquanto seu PC fica em uma mesa com refrigeração a ar, os supercomputadores da NASA exigem infraestrutura de resfriamento industrial, fornecimento elétrico dedicado e redes de alta largura de banda.

O que esses gigantes realmente fazem?

Você já se perguntou para que serve tanto poder computacional? Os computadores da NASA não estão rodando jogos ou renderizando vídeos - eles estão resolvendo alguns dos problemas mais complexos da ciência moderna.

Entre as aplicações mais importantes estão:

Análises climáticas globais - projetos como o ECCO2 estudam a circulação dos oceanos e o impacto do aquecimento global

Simulações de voos e aeronaves - desenvolvendo modelos que reduzem o ruído e melhoram a eficiência de aviões

Cálculos orbitais e dinâmicos - prevendo rotas seguras para missões espaciais tripuladas e robóticas

Astrofísica e cosmologia - simulando formação de galáxias, matéria escura e detecção de exoplanetas

Essas tarefas exigem bilhões de operações por segundo, o que explica por que a NASA investe em clusters modulares, processadores de ponta e GPUs científicas como as NVIDIA A100 e H100. Cada simulação pode consumir recursos que fariam qualquer PC comum travar em segundos.

Onde a NASA se posiciona no cenário global

Aqui está algo que pode surpreender: mesmo com todo seu poder, os supercomputadores da NASA não estão entre os mais rápidos do mundo em desempenho bruto. Por quê? A agência prioriza estabilidade, precisão científica e disponibilidade constante, não apenas recordes de velocidade.

Os rankings internacionais como o TOP500 mostram máquinas como o El Capitan (1,742 exaflops) e o Frontier (1,353 petaflops) superando amplamente os sistemas da NASA em termos de velocidade pura. Mas essas comparações não contam a história completa.

As máquinas da NASA são projetadas para funcionar por longos períodos, executando milhões de tarefas simultâneas sem falhas. Elas precisam de uma arquitetura equilibrada entre velocidade, memória e eficiência energética - características essenciais para simulações que podem durar semanas ou até meses.

Enquanto sistemas como o El Capitan focam em simulações nucleares e de energia avançada, os computadores da NASA se especializam em aplicações aeroespaciais, climáticas e de exploração espacial. Cada um tem seu propósito específico dentro do ecossistema científico global.

O que realmente diferencia esses sistemas

Quando você olha para além dos números impressionantes, percebe que a verdadeira diferença está na arquitetura desses sistemas. Enquanto seu PC doméstico tem uma CPU, algumas GPUs e memória RAM compartilhada, os supercomputadores da NASA funcionam como orquestras bem afinadas onde cada instrumento toca em perfeita sincronia.

O que mais me fascina é como eles lidam com a comunicação entre nós. Imagine ter que coordenar 370 mil núcleos de processamento trabalhando no mesmo problema - se um deles ficar ligeiramente atrasado, pode comprometer toda a simulação. Por isso, eles utilizam redes InfiniBand que alcançam velocidades de 200 Gb/s, praticamente eliminando gargalos de comunicação.

E não é só sobre velocidade - é sobre confiabilidade. Um PC comum pode travar uma vez por mês sem grandes consequências, mas um supercomputador da NASA executando uma simulação de reentrada atmosférica não pode falhar. Eles implementam redundância em praticamente tudo: fontes de energia, sistemas de resfriamento, controladores de rede e até nos próprios nós de computação.

O desafio energético dos supercomputadores

Você já parou para pensar no consumo de energia dessas máquinas? Enquanto seu PC gamer consome entre 500W e 1000W durante o uso intensivo, os sistemas da NASA exigem infraestrutura elétrica equivalente a uma pequena cidade.

O Pleiades, por exemplo, consome cerca de 2,5 megawatts - suficiente para abastecer mais de 2.000 residências. E isso é apenas um dos vários sistemas em operação. Quando você soma tudo, a NASA precisa de subestações dedicadas apenas para alimentar seus centros de computação.

Mas aqui está algo interessante: a eficiência energética tornou-se uma prioridade absoluta. A agência investe pesado em tecnologias de resfriamento líquido e processadores mais eficientes porque, acredite, a conta de luz dessas máquinas pode chegar a milhões de dólares anualmente. Cada watt economizado significa mais recursos para pesquisa científica.

Nos últimos cinco anos, conseguimos quadruplicar o desempenho mantendo praticamente o mesmo consumo energético. Isso foi possível graças a avanços em arquitetura de processadores e técnicas de resfriamento mais eficientes

Engenheiro de infraestrutura do NAS Facility

Como os dados fluem através desses sistemas

Outro aspecto que poucas pessoas consideram é o movimento de dados. Enquanto você transfere arquivos de alguns gigabytes pelo Wi-Fi doméstico, os supercomputadores da NASA lidam com petabytes de informação diariamente.

Pense em uma simulação climática global: ela pode gerar centenas de terabytes de dados que precisam ser processados, armazenados e analisados em tempo quase real. O sistema de armazenamento precisa ser tão rápido quanto os processadores, caso contrário cria-se um gargalo que torna todo o poder computacional inútil.

E não se trata apenas de velocidade - é sobre hierarquia inteligente. Dados frequentemente acessados ficam em SSDs ultrarrápidos, informações de médio uso vão para arrays de discos tradicionais, e arquivamento de longo prazo utiliza fita magnética (que ainda é incrivelmente eficiente para armazenamento massivo).

O que me impressiona é como eles gerenciam essa complexidade. Sistemas de arquivos paralelos como o Lustre permitem que milhares de processadores acessem os mesmos dados simultaneamente sem conflitos - algo que seria impossível com sistemas de arquivos convencionais.

A evolução contínua dessas máquinas

Ao contrário do que muitos imaginam, os supercomputadores da NASA não são construídos uma vez e mantidos por décadas. Eles passam por upgrades constantes - é como trocar o motor de um carro em movimento.

Na prática, isso significa que enquanto algumas partes do sistema executam simulações críticas, outras estão sendo atualizadas com processadores mais recentes ou mais memória. A arquitetura modular permite essa evolução contínua sem interromper as operações científicas.

E aqui está um detalhe curioso: muitas vezes, a NASA não compra sistemas prontos. Eles trabalham em parceria com fabricantes como HPE, Dell e NVIDIA para desenvolver soluções personalizadas que atendam necessidades específicas das missões espaciais. É uma colaboração que vai muito além de uma simples transação comercial.

Estamos falando de engenheiros da NASA sentando com arquitetos de hardware para discutir instruções específicas do conjunto, latência de memória e eficiência de cache. Essas conversas técnicas influenciam diretamente o desenvolvimento futuro dos processadores que eventualmente chegarão aos PCs domésticos.

O papel crucial do software especializado

Hardware impressionante é apenas metade da equação. O que realmente diferencia esses sistemas é o software científico altamente especializado que eles executam.

Enquanto você usa Windows ou Linux desktop, os supercomputadores da NASA rodam sistemas operacionais científicos baseados em Linux, mas profundamente modificados para otimizar o desempenho em aplicações específicas. São removidos serviços desnecessários, otimizados schedulers de processos e implementados drivers personalizados para hardware científico.

Mas o mais importante são as aplicações científicas propriamente ditas. Desenvolver código que escala eficientemente para centenas de milhares de núcleos é um desafio monumental. Pequenas ineficiências que passariam despercebidas em um PC doméstico se tornam gargalos catastróficos quando multiplicadas por 200.000 processadores.

E não se trata apenas de velocidade - é sobre precisão numérica. Muitas simulações espaciais exigem cálculos com precisão estendida, usando 128 bits ou mais para representar números. Isso consome mais recursos, mas é essencial para garantir que uma trajetória calculada hoje ainda seja precisa daqui a seis meses, quando a sonda chegar ao seu destino.

O desenvolvimento desses softwares é um esforço contínuo que envolve dezenas de programadores, matemáticos e físicos trabalhando em conjunto. Cada linha de código é otimizada, testada e validada antes de ser usada em missões reais - afinal, vidas e bilhões de dólares em equipamentos dependem desses cálculos.

Com informações do: Adrenaline