À medida que os modelos de linguagem avançados se tornam mais complexos, com trilhões de parâmetros e raciocínios de longo prazo, um gargalo crítico emerge: onde armazenar a imensa quantidade de dados contextuais que eles geram? A NVIDIA acredita ter encontrado uma resposta que pode não apenas resolver esse problema, mas acelerar drasticamente a inferência de IA. A empresa revelou sua plataforma NVIDIA Inference Context Memory Storage, uma infraestrutura de armazenamento nativa para IA construída em torno do novo processador de dados BlueField-4. E os números prometidos são impressionantes.

O problema do cache de contexto e a solução da NVIDIA

Imagine ter uma conversa profunda com alguém, mas a cada minuto essa pessoa esquece o que foi dito anteriormente. É mais ou menos assim que funcionam muitos sistemas de inferência de IA atuais quando o "contexto" – o cache de chave-valor (KV cache) gerado durante o processamento – não é gerenciado de forma eficiente. Esse cache é vital para manter a coerência e a precisão em interações longas ou em sistemas com múltiplos agentes de IA conversando entre si.

O problema é que esse contexto costuma ficar preso na memória das GPUs individuais. Quando você precisa compartilhá-lo entre diferentes nós de processamento em um cluster – algo essencial para modelos grandes distribuídos – a latência sobe e o desempenho despenca. A abordagem tradicional simplesmente não escala.

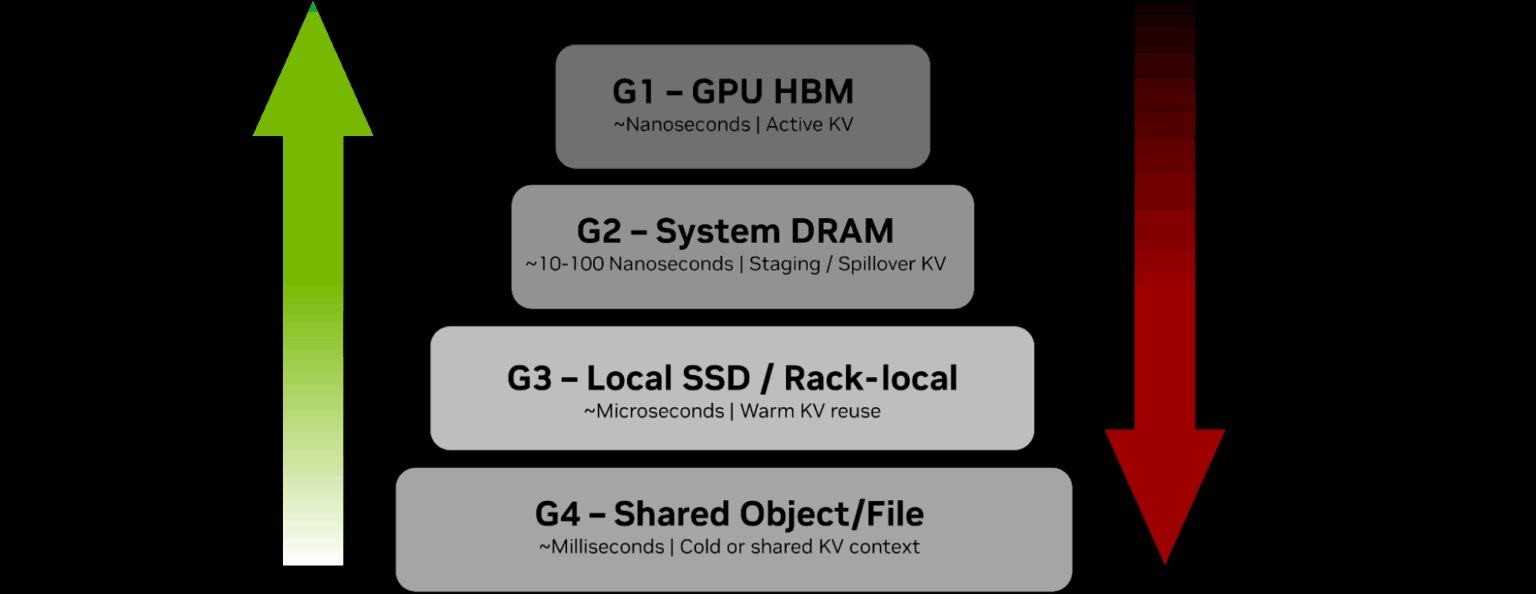

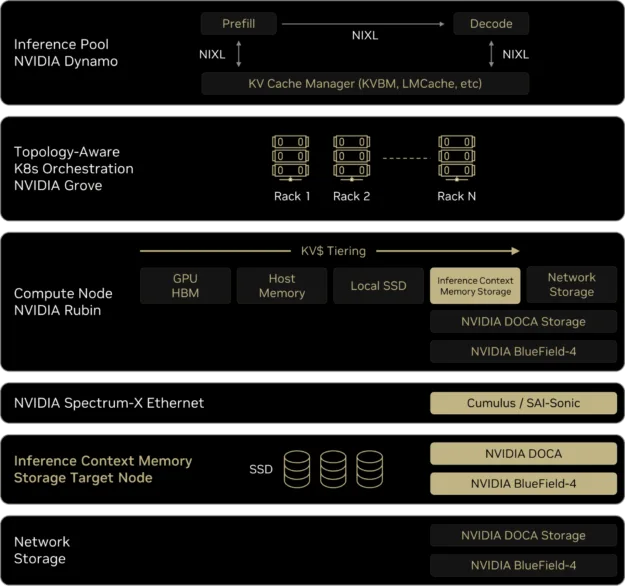

Aí que entra a plataforma da NVIDIA. Em vez de tratar o armazenamento como um componente passivo, eles o estão transformando em uma camada de aceleração ativa. A ideia é criar uma infraestrutura escalável que expanda virtualmente a capacidade de memória das GPUs e permita um compartilhamento rápido e eficiente de dados contextuais entre todos os nós do sistema.

Jensen Huang, o sempre emblemático CEO da NVIDIA, resumiu bem a mudança de paradigma. Ele disse que a IA moderna age como um colaborador que compreende contextos, raciocina em longo prazo e mantém memórias. E um colaborador desses exige uma pilha de tecnologia completamente nova, da computação até o armazenamento. Parece que é exatamente isso que eles estão entregando.

O coração do sistema: capacidades do BlueField-4

Tudo gira em torno do processador de dados BlueField-4. Não é apenas um chip de rede mais rápido; ele foi projetado com funcionalidades específicas para o gargalo do contexto de IA. Uma das mais interessantes é o posicionamento de cache gerenciado por hardware. Em termos simples, o próprio hardware decide onde armazenar e como recuperar os dados do cache de contexto, reduzindo drasticamente a sobrecarga de metadados que normalmente caberia ao software. Isso libera recursos preciosos da CPU e da GPU.

Mas de nada adianta ter um cache rápido se você não consegue acessá-lo de outros lugares do cluster. É aí que a integração com a rede NVIDIA Spectrum-X Ethernet se torna crucial. Ela permite algo chamado acesso direto à memória (RDMA) em escala, fazendo com que um nó de processamento possa "enxergar" e usar a memória de contexto armazenada em outro nó quase como se fosse local. A latência cai, e a eficiência sobe.

E os benefícios de desempenho prometidos são o que realmente chamam a atenção. A NVIDIA afirma que essa arquitetura pode aumentar o número de tokens processados por segundo em até 5x. Em um mundo onde tempo de resposta é dinheiro – literalmente, em custos de cloud computing – isso é uma mudança de jogo. Para completar, eles também prometem um ganho de eficiência energética na mesma proporção, até 5x. Considerando o apetite energético dos data centers de IA, essa é uma promessa tão importante quanto a de velocidade.

ProdutoPlataforma NVIDIA Inference Context Memory Storage.Componente centralProcessador de dados NVIDIA BlueField-4.Função principalInfraestrutura de armazenamento nativa para inteligência artificial (IA).Problema resolvidoArmazenamento e compartilhamento do cache de chave-valor (KV) de modelos de IA.Benefício de desempenhoAté 5x mais tokens por segundo.Benefício de eficiênciaAté 5x maior eficiência energética.Redes compatíveisNVIDIA Spectrum-X Ethernet.Parceiros anunciadosAIC, Cloudian, DDN, Dell, HPE, Hitachi Vantara, IBM, Nutanix, Pure Storage, Supermicro, VAST Data, WEKA.DisponibilidadeSegundo semestre de 2026

O ecossistema e o que esperar

Uma tecnologia revolucionária precisa de adoção para decolar, e a NVIDIA parece ter aprendido essa lição. Eles já anunciaram uma lista robusta de parceiros do setor de armazenamento que estão desenvolvendo produtos baseados nessa plataforma. São nomes pesados: Dell Technologies, HPE, IBM, Pure Storage, VAST Data, entre outros. Essa ampla apoio desde o lançamento é um sinal forte de que a indústria vê valor – e demanda – na solução.

Marcio Aguiar, diretor da divisão Enterprise da NVIDIA para a América Latina, enfatizou que o BlueField-4 foi criado para atender a demanda por modelos com contexto extenso e inferência contínua. "O armazenamento passa a ser um componente de aceleração", ele explicou. Essa mudança na narrativa – de armazenamento como depósito para armazenamento como acelerador – é, na minha opinião, a parte mais fascinante de todo o anúncio.

Claro, há um porém: tempo. A previsão de lançamento para o mercado é o segundo semestre de 2026. No ritmo acelerado do mundo da IA, isso é uma eternidade. Muita coisa pode mudar, e concorrentes certamente não ficarão parados. A NVIDIA está basicamente traçando o mapa da estrada para os próximos dois anos e desafiando o mercado a segui-lo.

Enquanto aguardamos 2026, a NVIDIA continua expandindo seu domínio além das GPUs. Se interessou por esse tipo de inovação em infraestrutura? Vale a pena dar uma olhada em outros anúncios recentes, como a confirmação de que a série RTX 50 SUPER não será mostrada na CES 2026, os novos recursos de upscaling com o anúncio do DLSS 4.5 e Multi Frame Generation 6X, e os compactos supercomputadores de mesa DGX Spark e DGX Station para modelos de IA massivos.

Fonte: Blog oficial de desenvolvedores da NVIDIA

Mas como exatamente essa "aceleração via armazenamento" funciona na prática? Vamos pensar em um exemplo concreto. Imagine um modelo de IA que está processando um documento jurídico de 500 páginas para extrair cláusulas específicas. Tradicionalmente, o contexto desse documento inteiro – ou grandes partes dele – precisaria ser mantido na memória de uma ou mais GPUs durante toda a análise. Com a plataforma da NVIDIA, esse contexto massivo pode ser armazenado de forma persistente e distribuída na infraestrutura de armazenamento, sendo puxado para a memória da GPU sob demanda, em pedaços, com latência extremamente baixa. É como se a GPU tivesse uma memória de trabalho quase infinita, sem o custo proibitivo de equipá-la com terabytes de RAM própria.

E isso abre portas para aplicações que hoje são praticamente inviáveis. Sistemas de IA conversacional que podem manter o contexto de uma conversa por dias ou semanas, não apenas minutos. Agentes de IA que colaboram em projetos complexos, compartilhando uma memória de trabalho comum e atualizada em tempo real. Ou até mesmo o treinamento de modelos, onde checkpoints e estados intermediários poderiam ser trocados entre nós de forma muito mais ágil. A promessa vai muito além de apenas "inferência mais rápida"; é sobre permitir novos comportamentos e capacidades para a IA.

Os desafios por trás da promessa

Claro, arquiteturas tão ambiciosas sempre vêm com seus próprios conjuntos de desafios. Um deles é a complexidade de software. Criar um sistema onde o hardware gerencia o posicionamento do cache é brilhante para desempenho, mas exige que todo o stack de software – desde os frameworks de IA como TensorFlow ou PyTorch até os sistemas operacionais e orquestradores como Kubernetes – seja adaptado para aproveitar essas novas capacidades. A NVIDIA terá que trabalhar em estreita colaboração com a comunidade de desenvolvedores para que a adoção seja suave. Do contrário, corre o risco de criar uma solução tecnicamente superior, mas complicada demais para implementar no mundo real.

Outro ponto é a dependência do ecossistema. A eficiência de 5x prometida não é um número mágico que surge do BlueField-4 sozinho. Ele depende da integração perfeita com as GPUs NVIDIA (as Hopper e suas sucessoras), com a rede Spectrum-X e com os sistemas de armazenamento dos parceiros. É uma aposta em um stack totalmente NVIDIA. Para empresas já investidas nesse ecossistema, é uma evolução natural. Para aquelas com infraestruturas mais heterogêneas, pode representar um custo de entrada considerável.

E não podemos ignorar a concorrência. A AMD, com sua arquitetura Instinct e a aquisição da Pensando, também tem seus próprios processadores de dados inteligentes. Empresas como Intel (com seus chips IPU) e até mesmo gigantes de cloud como AWS (com seus Nitro Systems) e Google têm visões diferentes sobre como descarregar e acelerar funções da CPU. O mercado de infraestrutura acelerada para data centers está longe de ser um monopólio. A NVIDIA está lançando um padrão, mas será que o mercado vai segui-lo?

Além do hardware: o papel crucial do software e dos padrões

Falando em padrões, uma parte subestimada desse anúncio é o software que vai orquestrar tudo isso. A NVIDIA mencionou o NVIDIA AI Enterprise e suas ferramentas de orquestração, mas o verdadeiro cerne pode estar em APIs e protocolos abertos. Para que essa visão de memória de contexto compartilhada e unificada funcione em escala, é necessário um protocolo de comunicação eficiente e padrão entre o armazenamento, a rede e as GPUs. Algo que vá além dos drivers proprietários.

Será que veremos a proposta de uma nova extensão para protocolos como NVMe-oF (NVMe over Fabrics) para cargas de trabalho de IA? Ou a criação de uma camada de abstração de memória, semelhante ao CXL (Compute Express Link), mas otimizada especificamente para o cache de contexto de modelos? A NVIDIA tem a oportunidade – e a influência – para tentar ditar esse padrão. Se conseguir, consolidará ainda mais sua posição. Se falhar, pode fragmentar o mercado e limitar a adoção.

Na minha experiência, é nesses detalhes de software e interoperabilidade que grandes inovações de hardware frequentemente tropeçam. O BlueField-4 pode ser um monstro de capacidade, mas seu sucesso comercial dependerá de quão fácil for para um engenheiro de ML implantar um modelo e, magicamente, ter todo esse gerenciamento de contexto complexo acontecer nos bastidores, sem precisar reescrever código.

E isso nos leva a um último ponto de reflexão: o custo total de propriedade (TCO). A NVIDIA enfatiza os ganhos de 5x em desempenho e eficiência. Mas quanto custará um sistema completo equipado com BlueField-4, Spectrum-X e armazenamento compatível? O aumento na densidade de tokens por segundo justificará o investimento inicial? Para hyperscalers como Microsoft Azure, Google Cloud e AWS, que operam na escala de centenas de milhares de GPUs, qualquer ganho de eficiência se traduz em milhões de dólares economizados em energia e capacidade. Para eles, o cálculo é quase certo. Para empresas menores, a equação pode ser mais delicada.

O que é inegável é a direção do vento. A era de tratar a IA como uma aplicação que roda em silos de computação isolados está chegando ao fim. O futuro, como a NVIDIA está desenhando, é de infraestruturas integradas e conscientes da carga de trabalho, onde computação, rede e armazenamento colaboram de forma ativa para otimizar um fluxo de dados específico: o da inteligência artificial. O BlueField-4 é um passo ousado nessa jornada. Resta saber se o mercado está pronto para dar o próximo passo junto com eles, ou se surgirão atalhos inesperados nesse caminho que se estende até 2026 e além.

Com informações do: Adrenaline