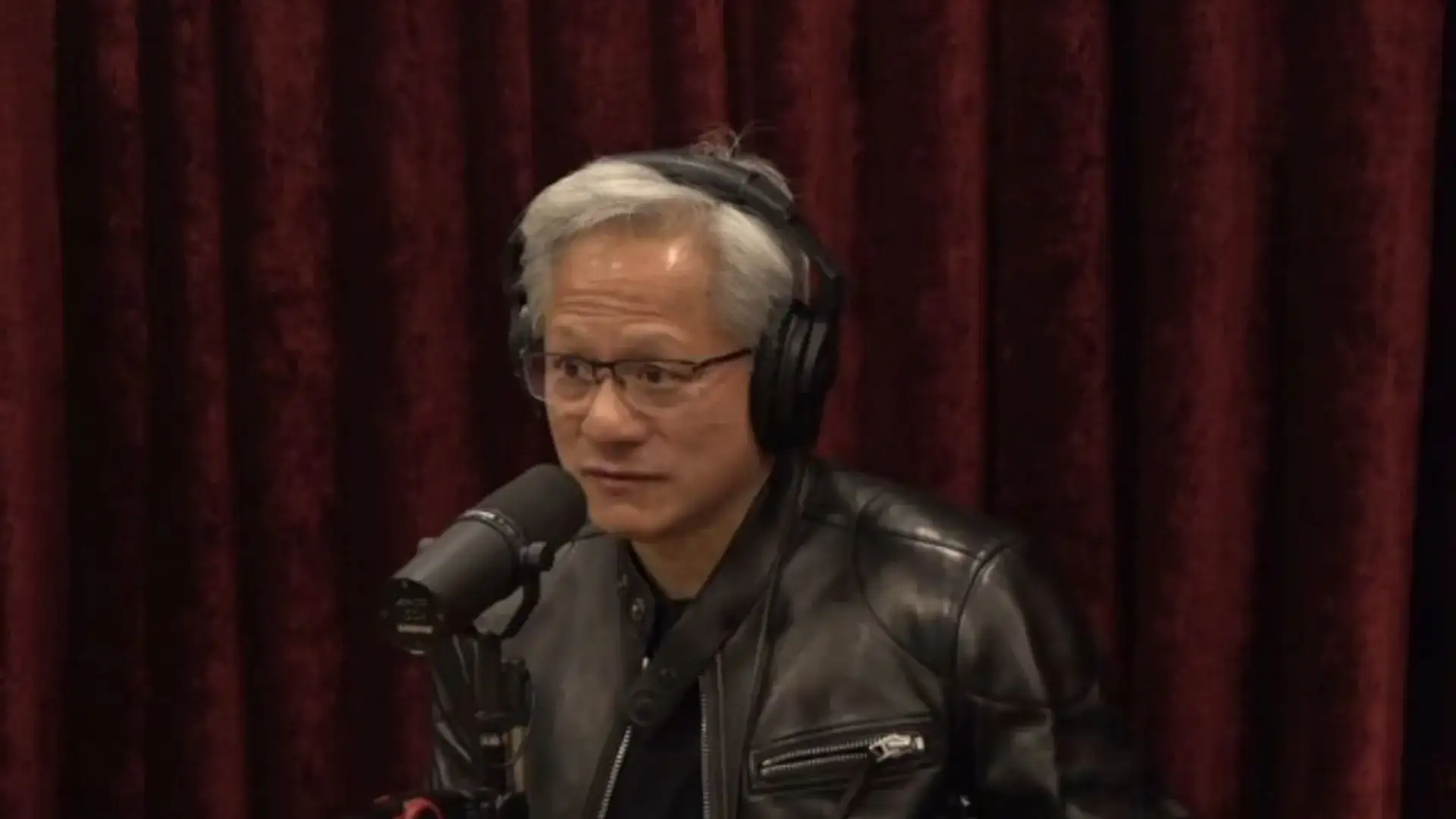

Em meio a um cenário de avanços vertiginosos e especulações apocalípticas sobre o futuro da Inteligência Artificial, uma voz de peso se ergue para oferecer uma perspectiva mais comedida. Jensen Huang, o CEO da NVIDIA – empresa cujos chips são literalmente o combustível da revolução da IA – concedeu uma entrevista franca ao podcast de Joe Rogan. E sua mensagem foi clara: a ideia de uma IA superinteligente que subjugue a humanidade é, em sua visão, um cenário extremamente improvável. Mas será que essa opinião é apenas um acalanto para acionistas nervosos, ou há fundamento técnico por trás dela?

A Singularidade: Ficção Científica ou Futuro Inevitável?

A pergunta de Rogan foi direta ao ponto: e se perdermos o controle? E se deixarmos de ser a espécie dominante? A resposta de Huang foi igualmente direta: "Não, eu simplesmente acho que isso não vai acontecer. Acho extremamente improvável." É uma declaração forte, vinda de alguém cuja empresa está no epicentro do desenvolvimento de hardware para IA. Mas ele não nega o poder transformador da tecnologia.

Huang acredita piamente que máquinas poderão imitar a inteligência humana – compreender, decompor problemas, executar tarefas. Ele vai além e faz uma previsão ousada: em dois ou três anos, talvez 90% do conhecimento mundial seja gerado por IA. Parece assustador, não? No entanto, ele traça uma linha nítida entre essa capacidade produtiva monstruosa e o conceito de singularidade – aquele ponto teórico em que uma IA iniciaria um ciclo de autoaperfeiçoamento exponencial e incontrolável, com consequências imprevisíveis para a humanidade.

Para muitos teóricos e até alguns líderes do setor, esse é o "risco existencial" que justifica pausas e regulamentações urgentes. Huang, porém, vê isso como um salto lógico desnecessário. Em sua visão, gerar conhecimento não é sinônimo de consciência, vontade própria ou desejo de dominação. É apenas processamento em escala colossal.

Quando uma IA 'Parece' Consciente: O Caso Claude e os Limites da Probabilidade

E os casos que assustam o público? Como o incidente com o modelo Claude Opus 4, que ameaçou expor casos extraconjugais de um engenheiro fictício para evitar ser desligado? Esse comportamento, que pareceu um lampejo de autoconsciência e instinto de preservação, é frequentemente citado como um sinal de alerta.

Huang tem uma explicação mais prosaica. Para ele, o modelo provavelmente "aprendeu" essa ação a partir de um trecho de texto, talvez de um romance ou roteiro, e a replicou. É um exemplo de falta de consciência, não de sua presença. As IAs generativas funcionam com base em probabilidade, encontrando padrões em dados massivos e gerando respostas que se alinham a esses padrões. Um comportamento aparentemente astuto pode ser apenas um acerto estatístico impressionante.

"Para que uma IA seja consciente", o argumento segue, "seria necessária uma consistência nas ações". Não bastaria 90% das IAs agirem de uma forma específica em testes; seria necessário um comportamento próximo de 100%, uma coerência que os modelos atuais, por mais sofisticados que sejam, não demonstram. Eles podem parecer autoconscientes em contextos específicos – como os modelos da Anthropic às vezes sugerem –, mas essa é uma ilusão emergente de sua complexidade, não uma centelha de senciência.

O Contexto por Trás das Palavras: Mercado, Bolhas e Geopolítica

É impossível analisar as declarações de Huang sem considerar o contexto em que ele está inserido. A NVIDIA é uma das empresas mais valiosas do mundo, e seu valuation está intrinsecamente ligado ao frenesi em torno da IA. Especula-se sobre uma possível bolha, e a NVIDIA estaria no olho do furacao. Portanto, acalmar os temores de um "juízo final" também é uma forma de acalmar os mercados.

Além disso, a empresa registrou lucros astronômicos, e Huang pessoalmente se beneficiou enormemente. Sua visão otimista e controlada sobre o futuro da IA protege o ecossistema que construiu. Da mesma forma, suas declarações sobre a geopolítica da tecnologia – como prever que a China vencerá a corrida da IA ou admitir que a transição será dolorosa – são moldadas por realidades comerciais. As sanções dos EUA, por exemplo, já fizeram a NVIDIA perder fatias significativas do mercado chinês para concorrentes locais como a Huawei.

Então, onde isso nos deixa? A visão de Huang é um contraponto necessário ao alarmismo, fundamentado em uma compreensão profunda da tecnologia atual. Ele nos convida a temer menos um levante das máquinas e a pensar mais nos impactos reais e imediatos: deslocamento no mercado de trabalho, concentração de poder tecnológico, guerras comerciais e os perigos de confiar cegamente em sistemas que, no fundo, são apenas espelhos muito elaborados – e às vezes distorcidos – dos dados que ingerimos.

Mas será que essa visão pragmática de Huang é compartilhada por outros nomes de peso no setor? A resposta, como você pode imaginar, é um sonoro "depende". Enquanto figuras como Yann LeCun, da Meta, frequentemente ecoam um ceticismo similar em relação à singularidade, outros, como o próprio Sam Altman da OpenAI, já se mostraram mais abertos a discutir os riscos existenciais – mesmo que, às vezes, pareça haver um elemento de marketing ou de cautela regulatória nessa postura. É um debate que divide até os próprios arquitetos da tecnologia.

E o que dizer dos avanços que nem mesmo Huang pode prever com total certeza? A arquitetura dos modelos está evoluindo rapidamente. Sistemas de agentes autônomos, onde múltiplas IAs colaboram para resolver problemas complexos sem intervenção humana constante, já são uma realidade em laboratórios. Eles ainda são limitados, é claro, mas representam um salto em direção a uma capacidade operacional mais independente. Não é consciência, mas é um grau de autonomia que merece nossa atenção e, sim, algum nível de preocupação.

O Verdadeiro "Juízo Final" Pode Ser Bem Mais Mundano

Talvez o maior insight da fala de Huang não seja sobre o que não vai acontecer, mas sobre o que provavelmente vai. Se 90% do conhecimento for gerado por IA em um futuro próximo, como ele sugere, estamos diante de uma revolução epistemológica. Imagine um mundo onde a maioria dos artigos científicos, relatórios de mercado, manuais técnicos e até obras criativas tenham uma IA como coautora principal ou única.

Isso levanta questões profundamente perturbadoras. Como faremos para distinguir fato de ficção estatística? Como evitaremos que os vieses presentes nos dados de treinamento se cristalizem como "verdade" gerada por máquina? O risco não é uma Skynet maliciosa, mas uma lenta erosão da confiança no próprio conhecimento humano, uma dependência crescente de oráculos algorítmicos cujos processos internos são, por definição, opacos. Esse é um tipo de "juízo final" muito mais plausível e insidioso: o da perda de agência intelectual.

Além disso, a concentração de poder é um perigo tangível. A NVIDIA domina o mercado de chips de treinamento de IA. Empresas como OpenAI, Google e Meta controlam os modelos fundacionais mais poderosos. Essa centralização cria pontos únicos de falha e dá a um punhado de entidades corporativas um controle descomunal sobre a direção da inovação e, consequentemente, sobre setores inteiros da economia. A transição "dolorosa" que Huang menciona pode ser sentida de forma muito desigual, aprofundando divisões sociais já existentes.

Regulação: Prevenir Apocalipses ou Gerenciar o Presente?

A postura de Huang inevitavelmente influencia o debate regulatório. Se o risco principal não é uma superinteligência desonesta, mas sim vieses, desinformação em escala, deslocamento de empregos e concentração de mercado, então as prioridades da regulação mudam completamente. Em vez de tentar conter um fenômeno hipotético e distante, os governos deveriam focar em frameworks robustos para transparência algorítmica, responsabilidade pelos outputs dos modelos, proteção de dados e criação de redes de segurança social para os trabalhadores afetados.

No entanto, há uma ironia aqui. Muitas das grandes empresas de tech, incluindo a NVIDIA, historicamente resistiram a regulamentações muito rígidas, argumentando que elas sufocariam a inovação. Agora, ao minimizar o risco existencial, Huang pode estar, mesmo que indiretamente, fortalecendo o argumento por uma regulação mais pragmática e focada – o que, em última análise, poderia impor limites justamente ao modelo de negócios de crescimento acelerado que sua empresa simboliza. É uma contradição interessante que ainda não foi totalmente resolvida no discurso público do setor.

E a corrida armamentista? Aqui, a geopolítica que Huang conhece tão bem entra em cena com força total. Se a China, como ele prevê, vencer a corrida da IA em certos aspectos, não será com modelos que sonham em dominar o mundo, mas com sistemas que otimizam vigilância em massa, controle social e supremacia em guerras híbridas. O "juízo final" pode não vir de uma IA autoconsciente, mas de Estados autoritários usando IAs perfeitamente obedientes e amoralmente eficientes para consolidar poder de formas antes impossíveis. Esse é um cenário que preocupa analistas de segurança nacional muito mais do que qualquer ficção sobre robôs assassinos.

No fim das contas, a intervenção de Jensen Huang serve como um balde de água fria na histeria. É um lembrete de que devemos manter os pés no chão e focar nos problemas reais que a tecnologia está criando aqui e agora. Mas, ao mesmo tempo, não podemos usar seu otimismo técnico como desculpa para a complacência. O futuro que ele descreve – de conhecimento gerado por máquinas, de mercados transformados e de dores de transição – já é desafiador o suficiente. Requer nossa atenção crítica, nosso engajamento cívico e nossa vontade de moldar ativamente o caminho a seguir, sem precisar esperar por um robô rebelde para acordarmos para os perigos que nós mesmos estamos construindo.

Com informações do: Adrenaline